인공지능(AI)은 21세기 기술 혁명의 선두에 서서 우리 사회의 패러다임을 근본적으로 변화시키고 있습니다.

챗GPT와 같은 거대 언어 모델(LLM)부터 자율주행, 정밀 의료에 이르기까지, AI는 이제 단순한 기술적 진보를 넘어 문명 전반의 진화를 이끄는 핵심 동력으로 자리매김했습니다.

그러나 이러한 눈부신 발전의 이면에는 우리가 직시해야 할 거대한 그림자가 드리워져 있습니다.

바로 AI 데이터센터의 폭발적인 전력 소비 증가라는 현실입니다.

이 블로그 시리즈 'AI 시대의 그림자'의 첫 번째 편에서는 AI 기술 발전이 야기하는 에너지 소비 문제의 심각성을 심층적으로 분석하고, 그 근본적인 원인과 현재의 상황, 그리고 지속 가능한 미래를 위한 다각적인 대책을 냉철하게 제시하고자 합니다.

📊 1. AI 시대, 전력 수요 폭증의 현황과 예측

전 세계 데이터센터의 전력 사용량은 급격히 증가하고 있습니다.

국제에너지기구(IEA)에 따르면, 전 세계 데이터센터의 전력 사용량은 2022년 약 460 TWh¹ 에서 2026년에는 1,050 TWh로 두 배 이상 증가할 것으로 전망됩니다.

블룸버그NEF(BloombergNEF)의 장기 전망은 더욱 가파른 증가세를 예측합니다.

전 세계 데이터센터의 전력 수요는 2035년까지 1,200 TWh에 달하고, 2050년에는 무려 3,700 TWh에 이를 것으로 예상됩니다.

특히 AI 전용 데이터센터의 전력 수요는 2030년까지 현재의 네 배 이상 증가할 것으로 예측됩니다.

이러한 AI 관련 전력 수요 증가는 전기차나 수소와 같은 다른 신흥 분야의 전력 수요 증가 속도를 훨씬 능가하는 수준입니다.

🌎 지역별로 살펴보면, 미국의 경우 블룸버그NEF는 데이터센터 전력 수요가 2024년 약 35 GW² 에서 2035년에는 78 GW로 두 배 이상 증가할 것으로 예측하며, 평균 시간당 전력 소비량은 16 GWh³ 에서 49 GWh로 거의 세 배 증가할 것으로 전망합니다.

특히 주요 데이터센터 허브인 북부 버지니아 지역에서는 이미 데이터센터가 버지니아주 전체 전력 수요의 25%를 차지하고 있어, 공급이 수요를 초과하여 순환 정전이 발생할 수 있다는 우려가 제기되고 있습니다.

📈 전체 전력 수요에서 AI가 차지하는 비중도 크게 늘어날 것으로 보입니다.

전력연구소(EPRI)는 2030년까지 데이터센터의 전력 소비량이 두 배 이상 증가하여 미국 전체 전력 수요의 9%를 차지할 수 있다고 예측합니다 (2023년 4.4%에서 증가).

전 세계적으로는 SPhotonix의 추정치에 따르면 2030년까지 데이터센터가 전체 전력 수요의 최대 13%를 차지할 수 있습니다.

⚙️ 이러한 막대한 전력 수요 증가는 단순한 소비량 증가를 넘어 보이지 않는 인프라 압박으로 이어집니다.

수치로 나타나는 대규모 전력 수요는 물리적인 발전 및 송전 인프라에 대한 직접적인 요구로 해석될 수 있습니다.

연구에 따르면 이러한 수요 증가를 충족하기 위해서는 33 GW에서 91 GW에 달하는 새로운 발전 용량이 필요할 수 있습니다.

이는 AI 전력 수요의 급격한 증가 속도와 에너지 인프라 개발의 느린 속도 사이에 상당한 시간적 불일치가 존재함을 시사합니다.

데이터센터 개발에만 초기 단계부터 완전 운영까지 약 7년이 소요되며, 소형모듈원전(SMR)과 같은 유망한 청정에너지 솔루션도 2030년경에나 상용화될 것으로 예상됩니다.

(업데이트: 2025년 현재, 일부 SMR 프로젝트는 상용화 일정이 다소 지연될 가능성이 제기되고 있으며, 이는 단기적인 전력 공급 계획에 더욱 신중한 접근을 요구하고 있습니다.)

이러한 시간적 격차는 단기 및 중기적으로 급증하는 수요가 기존 전력망에 부담을 주거나(북부 버지니아 사례처럼 잠재적인 정전 발생 가능성) 혹은 보다 쉽게 확보할 수 있는 화석 연료 기반의 전력원에 대한 의존도를 높일 수 있음을 의미합니다.

결과적으로 AI의 에너지 발자국은 단순한 소비를 넘어 전 세계 에너지 안보에 대한 시스템적 스트레스를 유발하고, 긴급한 전력 수요가 지속 가능성보다 가용성을 우선시하게 만들면서 기후 목표 달성을 저해할 수 있다는 우려를 낳고 있습니다.

🧠 2. AI가 전기를 '먹는' 이유: GPU, 냉각, 학습 vs. 추론

AI 시스템이 이처럼 막대한 전력을 소비하는 근본적인 이유는 대규모 데이터 처리와 고성능 컴퓨팅 능력에 대한 요구사항 때문입니다.

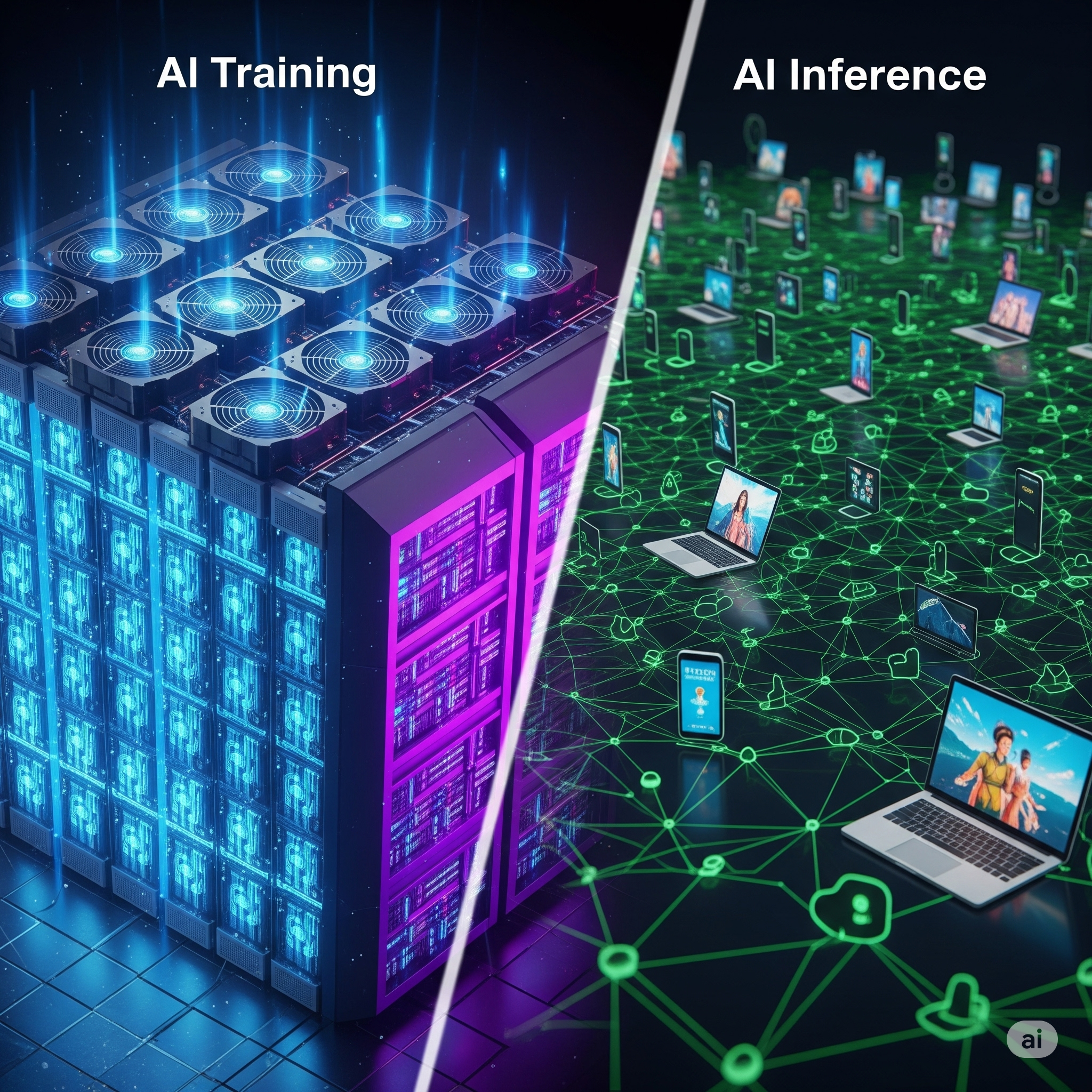

특히 AI의 학습(Training)과 추론(Inference)⁴ 과정은 데이터센터 내에 탑재된 그래픽 처리 장치(GPU)에 크게 의존합니다.

🔥 GPU의 전력 소비량은 지속적으로 증가하는 추세입니다.

엔비디아의 블랙웰(Blackwell) 라인업을 예로 들면, GB200 NVL72는 120kW⁵, 곧 출시될 GB300 랙은 140kW를 소비하여 기존 H200의 70kW에 비해 거의 두 배에 달합니다.

루빈(Rubin) 세대와 같은 미래 엔비디아 설계는 열 설계 전력(TDP)⁶ 을 블랙웰 대비 50% 증가시켜 랙당 최대 180kW에 이를 것으로 예상되며, 업그레이드된 베라 루빈(Vera Rubin)은 2027년까지 랙당 360kW로 두 배가 될 것으로 전망됩니다.

가장 큰 구성인 '카이버(Kyber)' 랙으로 불리는 베라 루빈 NVL576은 불과 2년 만에 GB200 NVL72의 5배인 600kW(0.6MW)를 소비할 수 있습니다.

엔비디아는 1MW 서버 랙을 목표로 하고 있으며, KAIST 연구원들은 2032년까지 가속기 서버 랙이 1.54MW에 이를 것으로 예측합니다.

이러한 고성능 프로세서의 증가는 직접적인 전력 소비 증가로 이어지며, 동시에 엄청난 양의 열을 발생시킵니다.

이 열을 식히기 위한 냉각 시스템에 막대한 에너지가 필요하게 되어 전체 전력 수요가 더욱 증가합니다.

⚙️ AI의 전력 소비는 크게 '학습'과 '추론' 두 가지 단계로 나눌 수 있습니다.

GPT-4와 같은 정교한 AI 모델을 학습시키는 데 약 30MW의 전력이 필요했습니다.

그러나 전력 수요 급증의 '주요' 요인은 바로 '추론' 단계입니다.

추론 작업에 대한 전력 수요는 2028년까지 연평균 122%의 빠른 속도로 증가할 것으로 예상됩니다.

보스턴 컨설팅 그룹(BCG)은 2028년까지 생성형 AI 추론만으로 전 세계 데이터센터 전력 수요의 3분의 1 이상을 차지할 것으로 추정합니다.

🗣️ 일반적으로 대중은 대규모 AI 모델을 훈련하는 데 드는 막대한 에너지 비용에 주목하지만, 추론이 전력 수요를 가속화하는 주요 동인이라는 점은 중요한 의미를 가집니다.

학습은 모델 개발을 위한 고비용의 일회성 또는 주기적인 이벤트인 반면, 추론은 사용자가 AI 모델과 상호작용할 때마다(예: 챗GPT에 질문할 때마다) 실행됩니다.

챗GPT 한 번의 질의는 일반적인 구글 검색보다 최대 10배 많은 에너지를 소비하며, 이는 전구 하나를 약 20분 동안 켤 수 있는 전력량과 맞먹습니다.

매일 수백만, 잠재적으로 수십억 명의 사람들이 다양한 작업을 위해 AI를 사용할 것이라는 점을 고려하면, 개별 추론 질의에서 발생하는 누적 에너지 수요는 기하급수적으로 증가할 수밖에 없습니다.

이는 전력 소비 문제가 AI 개발자에게만 국한된 문제가 아니라, 광범위한 사회적 에너지 문제로 변모하고 있음을 의미합니다.

생성형 AI의 광범위한 채택은 이 문제를 전문 산업 비용에서 전 세계 에너지 자원에 대한 근본적인 부담으로 변화시키고 있으며, 이는 단순히 학습 최적화를 넘어선 광범위한 사회 및 인프라 솔루션을 요구합니다.

⚡ 3. 전력난과 인프라 압박: 지역별 영향 및 공급 문제

AI 데이터센터의 막대하고 빠르게 증가하는 전력 수요는 기존 전력망에 상당한 부담을 가합니다.

이러한 전력망은 이미 기후 변화의 영향(예: 극심한 날씨, 폭염 시 냉각을 위한 에너지 수요 증가)과 전력 인프라의 혼란으로 인해 압박을 받고 있습니다.

예측되는 수요 증가를 충족하기 위해서는 33 GW에서 91 GW에 달하는 새로운 발전 용량이 필요할 수 있으며, 이는 막대한 투자와 개발 과제를 의미합니다.

⏳ 데이터센터 개발은 초기 단계부터 완전 운영까지 일반적으로 약 7년이 소요됩니다.

이러한 긴 개발 시간으로 인해 부지 선정은 가용한 전력망 용량, 신속한 상호 연결, 세금 혜택 및 적합한 토지를 갖춘 지역을 선호하는 기회주의적인 방식으로 이루어지고 있습니다.

이는 충분한 전력 인프라를 갖춘 부지를 확보하는 것이 점점 더 어려워지거나 경쟁이 심화되고 있음을 시사합니다.

🚧 AI 전력 수요의 기하급수적인 증가 속도와 새로운 에너지 인프라를 구축하는 데 필요한 훨씬 더 느린 시간 사이에 상당한 시간적 불일치가 존재합니다.

데이터센터 건설에 약 7년이 걸리고, 소형모듈원전(SMR)과 같은 첨단 에너지 솔루션도 2030년경에나 상용화될 것으로 예상된다는 점은 이러한 격차를 명확히 보여줍니다.

이로 인해 단기적으로는 즉각적인 전력 수요가 기존의 (종종 화석 연료에 의존하는) 전력망에 의해 충족될 가능성이 높습니다.

이는 다음과 같은 문제점들을 야기하며, 전력 인프라에 대한 심각한 스트레스를 초래합니다.

- 🚨 전력 공급 부족 및 안정성 위협:

급증하는 AI 데이터센터의 전력 수요는 기존 전력망의 용량을 빠르게 초과할 수 있습니다.

이는 전력망의 과부하를 유발하고, 예측 불가능한 정전 사태를 초래하여 국가 경제와 사회 시스템 전반에 치명적인 영향을 미칠 수 있습니다.

특히 전력 수요가 특정 지역(예: 수도권)에 집중될 경우, 지역 간 전력 수급 불균형 문제가 심화될 수 있습니다.

(업데이트: 2025년 현재, 일부 국가에서는 AI 데이터센터의 과도한 전력 수요로 인해 신규 데이터센터 허가 절차가 강화되거나, 기존 전력망 업그레이드에 대한 강제 조항이 추가되는 사례가 나타나고 있습니다.) - 💰 전력 요금 인상 압박:

전력 수요가 급증하면 전력 생산 및 인프라 확충에 드는 비용이 증가하게 되고, 이는 결국 소비자 및 기업의 전기 요금 인상으로 이어질 수 있습니다.

이는 AI 관련 산업뿐만 아니라 전반적인 산업 경쟁력 저하와 가계 부담 증가로 이어질 수 있습니다. - 🏗️ 인프라 건설 지연 및 경제적 손실:

전력 인프라 확충은 막대한 투자와 긴 건설 시간을 요구합니다.

AI 산업의 급속한 성장에 맞춰 전력 인프라를 신속하게 구축하지 못할 경우, AI 산업의 성장이 저해되고 국가 디지털 경쟁력이 약화될 수 있습니다.

핵심 자재 및 부품의 가격 급등과 공급 부족 또한 인프라 확충의 걸림돌로 작용합니다.

🌱 4. 지속 가능한 AI를 위한 다각적 대안과 효용

AI의 거대한 에너지 발자국은 더 이상 간과할 수 없는 문제이며, 이는 비단 기술 기업만의 문제가 아니라 전 지구적인 과제입니다.

우리는 다음과 같은 다각적인 노력을 통해 지속 가능한 AI 시대를 모색해야 합니다.

- 💡 기술적 접근: 하드웨어 및 소프트웨어 효율성 혁신

- 칩 💻 저전력 AI 칩 개발 (효용: 연산 효율 극대화, 전력 소비 원천 절감):

GPU를 넘어 AI 연산에 특화된 저전력 ASIC(Application-Specific Integrated Circuit)⁷ 및 뉴로모픽 칩⁸ 개발이 가속화되어야 합니다.

최근 연구팀들은 AI를 사용하여 LLM의 에너지 사용량을 50% 줄이는 새로운 칩을 시연하기도 했습니다 (Securities.io). 삼성은 AIoT 기기를 위한 NPU가 포함된 Exynos 시리즈를 출시하며 AI 칩 시장의 다변화를 이끌고 있으며, 삼성전자는 기존 대비 AI 가속기 성능은 2배 향상, 전력 소모는 50% 감소시킬 수 있는 'M-PIM' 제품을 개발했습니다.

이러한 저전력 칩은 초기 설계 단계에서부터 에너지 효율을 고려하여 전력 소비를 근본적으로 줄이는 데 기여합니다. - 냉각💧 차세대 냉각 기술 도입 (효용: 냉각 에너지 절감, 공간 효율성 증대):

기존의 공랭식 냉각 시스템에서 벗어나 액체 냉각(Liquid Cooling)⁹ 시스템을 도입하면 에너지 소비를 획기적으로 줄일 수 있습니다.

액체 냉각 방식은 공기보다 훨씬 높은 열전도율을 가지고 있어, 데이터센터의 발열 문제를 보다 효율적으로 해결하며, HVAC(Heating, Ventilation, and Air Conditioning)¹⁰ 시스템의 사용을 줄여 에너지 소비를 절감합니다 (Goover).

kt cloud는 액침 냉각 기술 검증(PoC)을 통해 서버실 유틸리티 전력량 58% 이상 절감, 서버실 전력량 15% 이상 절감, 서버실 면적 70% 이상 감소 등 긍정적인 결과를 입증했습니다.

삼성전자와 LG전자 또한 LG유플러스의 데이터센터에 액체 냉각 솔루션인 냉각수 분배 장치(CDU)를 공급하며 기술 상용화를 이끌고 있습니다 (조선일보).

네이버의 '각 세종' 데이터센터는 바람과 미스트를 이용한 친환경 냉각 기술로 연간 에너지 사용량을 57% 절감하는 성과를 보이기도 했습니다 (브런치스토리).

(업데이트: 2025년, 액체 냉각 기술은 상용 데이터센터에 더욱 폭넓게 적용되고 있으며, 냉각 효율을 극대화하기 위한 이중 액체 냉각¹⁶ 등 복합적인 냉각 방식 연구도 활발합니다.) - 알고리즘 ⚙️ AI 모델 경량화 및 알고리즘 최적화 (효용: 연산 자원 및 전력 소비 감소, 모델 배포 용이성 증대):

더 적은 매개변수로 유사한 성능을 내는 경량화된 AI 모델 아키텍처 개발이 중요합니다.

양자화(Quantization)¹¹, 가지치기(Pruning)¹², 지식 증류(Knowledge Distillation)¹³ 등의 기술을 통해 모델의 크기와 연산량을 줄일 수 있습니다.

카카오페이는 모델 서빙 최적화를 위한 프레임워크를 도입하고 AWS Inferentia를 활용하여 머신러닝 모델 서빙 비용을 1/4로 줄였습니다 (카카오페이 기술 블로그).

현대자동차그룹은 자율주행 AI 모델에 합성 데이터를 활용하고, 임베디드 보드 성능 예측 AI 모델을 개발하여 딥러닝 모델 경량화 및 최적화를 실무에 적용하고 있습니다 (HMG Developers).

한국에너지경제연구원(KEEI) 보고서에 따르면, LLM을 활용하여 AI 비용 50% 절감, 개발 시간 65% 단축, AI 전력 소비 15% 감소를 달성한 사례도 있습니다.

- 칩 💻 저전력 AI 칩 개발 (효용: 연산 효율 극대화, 전력 소비 원천 절감):

- 🏢 인프라 및 운영적 접근: 지속 가능한 데이터센터 구축

- ☀️ 재생에너지 사용 확대 (효용: 탄소 중립 달성, 장기적 운영 비용 절감):

데이터센터 전력을 태양광, 풍력 등 재생에너지로 100% 전환하는 노력이 가속화되어야 합니다.

구글, 마이크로소프트, 아마존 웹 서비스(AWS) 등 글로벌 빅테크 기업들은 이미 RE100을 선언하고 대규모 재생에너지 발전소와의 PPA(Power Purchase Agreement) 계약을 통해 재생에너지 사용을 확대하며 이러한 전환을 주도하고 있습니다 (디지털데일리, 아주경제, 인천투데이).

IEA는 2024~2030년 재생에너지가 데이터센터 전력 수요 증가분의 거의 절반을 충족시킬 것으로 전망합니다.

(업데이트: 2025년 현재, 재생에너지 공급의 간헐성¹⁷ 문제를 해결하기 위한 에너지 저장 시스템(ESS)¹⁸과의 연계 및 가상 발전소(VPP)¹⁹ 도입 논의가 활발히 이루어지고 있습니다.) - ⚡ 스마트 그리드 연동 및 에너지 관리 시스템 (효용: 전력망 안정화, 에너지 효율 극대화):

데이터센터가 스마트 그리드¹⁴와 연동되어 전력 수요 반응에 유연하게 대응하고, 잉여 전력을 활용하는 등의 효율적인 운영 방안을 모색해야 합니다.

구글은 AI를 활용해 데이터센터의 냉각 시스템을 최적화함으로써 냉각 에너지를 40% 절감하는 성과를 거두었습니다 (재능넷).

미국 캘리포니아주는 AI 기반 스마트그리드를 통해 피크 시간대 전력 수요를 15% 감소시키고 정전 사고를 줄였습니다 (재능넷).

한국에서도 제주 스마트 그리드 실증단지, 대구 ESS 실증사업 등을 통해 스마트 그리드 기술이 실증 및 적용되고 있습니다 (velog). - 🗺️ 모듈형 데이터센터 및 입지 선정 최적화 (효용: 전력 인프라 부담 분산, 자연 냉각 활용):

전력 공급이 용이하고 자연 냉각에 유리한 지역에 모듈형 데이터센터를 분산 배치하는 방식은 특정 지역의 전력망 부담을 줄이고 에너지 효율을 높이는 데 기여할 수 있습니다.

Baidu, Alibaba, Tencent 등 중국의 주요 인터넷 기업들은 이미 새로운 데이터센터 구축에 모듈형 방식을 선택하여 구축 기간 단축과 에너지 소비 및 비용 절감 효과를 거두고 있습니다 (Delta Power Solutions).

이러한 모듈형 데이터센터는 AI/ML 기반의 자동 냉각 제어와 전력 최적화 기술이 접목되고 있습니다 (ITPE * JackerLab).

- ☀️ 재생에너지 사용 확대 (효용: 탄소 중립 달성, 장기적 운영 비용 절감):

- 🏛️ 정책 및 제도적 접근: 정부와 산업계의 협력

- 📊 지속 가능한 AI 지표 개발 및 규제 (효용: 기업의 책임감 고취, 투명한 정보 공개):

액센추어가 제안한 '지속가능성 조정 지능 지수(Sustainable AI Quotient, SAIQ)'와 같이 AI 시스템의 비용, 전력, 물 사용량 등을 종합적으로 측정하는 지표 개발 및 적용이 필요합니다 (지디넷코리아).

SAS와 같은 기업들도 '2025 인공지능 트렌드 전망'을 통해 규제와 환경적 지속가능성이 주요 이슈가 될 것으로 내다보며 클라우드 업체와 AI 사용자가 환경적 책임을 함께 공유해야 함을 강조하고 있습니다 (GS칼텍스 미디어허브).

한국지능정보사회진흥원(NIA)의 보고서에 따르면, 국가 디지털 전략에서 정량적 목표를 통해 점검하는 국가의 비율이 2021년 약 66%에서 2023년 89%로 증가하며 지속 가능성에 대한 관심이 높아지고 있습니다 (한국지능정보사회진흥원).

(업데이트: 2025년, 유럽연합(EU)의 AI Act²⁰ 등 주요 지역의 AI 규제 법안에 '환경적 영향 평가' 조항이 명시적으로 포함되는 추세이며, AI 시스템의 에너지 소비량 보고 의무화에 대한 논의도 활발합니다.) - 수급 💡 국가 차원의 전력 수급 계획 수립 (효용: 안정적인 전력 공급, 인프라 투자 효율성 증대):

한국과학기술기획평가원(KISTEP)은 AI 전용 칩 등으로 연산 효율이 향상되더라도 총 전력 소비가 증가하는 '제본스 역설(Jevons Paradox)'¹⁵ 을 지적하며, 국가 차원의 전력 공급 능력이 AI 혁신의 성패를 가늠하는 핵심 요소로 부상했다고 강조합니다.

정부는 국가 AI 컴퓨팅센터 구축(GPU 1.5만장급)과 슈퍼컴 6호기 구축(GPU 0.85만장급) 등을 가속화하고 있으며, 1.46조원 규모의 첨단 GPU 확보 추경 편성('25년)을 추진하고 있습니다 (기획재정부).

AWS는 국내 기업들에게 데이터 분석 및 AI 모델 설계를 지원하기 위해 2027년까지 58.8억 달러를 투자하여 인프라 구축을 강화할 계획이며, 비수도권 데이터센터 분산과 에너지 수급을 위한 안정적인 대책 마련이 시급함을 지적하고 있습니다 (Goover). - 혜택 💰 세금 감면 및 인센티브 제공 (효용: 친환경 기술 투자 유도, 재생에너지 전환 촉진):

재생에너지 사용, 고효율 장비 도입 등 친환경 데이터센터 구축 및 운영을 위한 기업들의 노력에 세금 감면이나 보조금 지급과 같은 인센티브를 제공하여 전환을 가속화해야 합니다.

한국산업은행은 AI 컴퓨팅 인프라 확충 사업에 출자하고, AI 컴퓨팅 인프라 지원을 위한 저리 대출 상품을 신설하여 2025년부터 2027년까지 총 2.5조원 한도 내에서 지원을 제공할 예정입니다 (기획재정부).

- 📊 지속 가능한 AI 지표 개발 및 규제 (효용: 기업의 책임감 고취, 투명한 정보 공개):

📢 결론: AI의 미래, 그리고 우리의 책임

AI는 분명 인류에게 혁명적인 도구를 제공하고 있지만, 그 이면의 거대한 에너지 소비는 우리가 직시해야 할 불편한 진실입니다.

IEA와 PwC 등 주요 기관들의 보고서는 AI의 전력 소비가 예측 불가능한 속도로 증가하고 있으며, 이는 전력 인프라 부족, 전력 요금 인상 등 다양한 사회적 문제로 이어질 수 있음을 경고합니다.

하지만 동시에, 전 세계적으로 다양한 주체들이 이러한 문제에 대응하기 위한 기술적, 인프라적, 정책적 노력을 실제적으로 추진하고 있음을 확인할 수 있습니다.

저전력 칩, 차세대 냉각 시스템, 모델 경량화, 재생에너지 전환, 스마트 그리드 연동, 국가 단위의 전력 수급 계획 수립 등 다각적인 접근이 이루어지고 있으며, 일부는 이미 유의미한 성과를 보이고 있습니다.

AI의 지속 가능한 발전을 위해서는 기술 혁신뿐만 아니라 에너지 효율성, 환경 보호, 사회적 책임이라는 가치를 최우선에 두어야 합니다. AI 기술 개발자와 사용자, 정책 입안자 등 모두가 이 문제에 대한 책임 의식을 가지고 긴밀하게 협력해야 합니다.

단순히 AI의 '가능성'에만 집중할 것이 아니라, 그 '영향'에 대한 깊이 있는 성찰과 실질적인 대응이 필요한 시점입니다.

📢 다음편 이 시리즈의 주제는 "🌍 환경에 드리운 AI의 그림자: 탄소, 물, 그리고 자원 고갈"입니다. AI 시대의 지속 가능성에 대한 더 깊은 논의에 함께해 주시길 바랍니다.

💡[ 02편 ]🌍 환경에 드리운 AI의 그림자: 탄소, 물, 그리고 자원 고갈

지난 'AI 시대의 그림자' 1편에서는 인공지능(AI)의 급격한 발전이 야기하는 데이터센터의 전력 소비 폭증 문제에 대해 심도 깊게 다루었습니다.하지만 AI의 환경적 영향은 단순히 전력 소비에만

dragonstone74.tistory.com

📚 용어 설명

- TWh (테라와트시): 전력량의 단위. 1 테라와트시(TWh)는 1조 와트시(Wh) 또는 10억 킬로와트시(kWh)와 같습니다. 국가나 대규모 산업 시설의 전력량을 나타낼 때 주로 사용되는 아주 큰 단위입니다.

- GW (기가와트): 전력의 단위로, 1 GW는 10억 와트(W) 또는 1,000 메가와트(MW)에 해당합니다. 대규모 발전소의 발전 용량이나 도시, 국가 단위의 전력 수요를 나타낼 때 사용됩니다.

- GWh (기가와트시): 전력량의 단위. 1 기가와트시(GWh)는 1 기가와트(GW)의 전력을 1시간 동안 사용했을 때의 총 전력량입니다. 1 GWh는 1,000 MWh(메가와트시)와 같습니다.

- 추론 (Inference): AI 모델이 학습을 마친 후, 새로운 데이터를 받아서 결과를 예측하거나 결론을 내리는 과정을 말합니다. 예를 들어, 챗봇이 여러분의 질문에 답을 하거나, AI가 사진 속 사물을 인식하는 것이 바로 추론 단계입니다.

- kW (킬로와트): 전력의 단위로, 1 kW는 1,000 와트(W)에 해당합니다. 개별 가전제품이나 소규모 설비의 전력 소비량을 나타낼 때 사용됩니다. 일반적인 헤어드라이어가 약 1~2kW 정도의 전력을 소비합니다.

- 열 설계 전력 (TDP, Thermal Design Power): 컴퓨터의 중앙처리장치(CPU)나 그래픽처리장치(GPU) 같은 부품이 최대한의 성능을 낼 때 발생하는 열량을 의미합니다. 이 열을 효과적으로 식히기 위해 냉각 시스템이 필요한데, TDP가 높을수록 더 강력한 냉각 시스템이 필요하고 이는 더 많은 전력 소비로 이어집니다.

- ASIC (Application-Specific Integrated Circuit): 특정 목적을 위해 특별히 설계된 반도체 칩입니다. 범용으로 쓰이는 칩(예: GPU)보다 특정 작업을 처리하는 데 훨씬 효율적이며, AI 연산에 특화된 ASIC은 전력 소모를 줄이면서 성능을 높일 수 있습니다.

- 뉴로모픽 칩 (Neuromorphic Chip): 사람의 뇌가 정보를 처리하는 방식(신경망)을 모방하여 만든 차세대 반도체 칩입니다. 기존 컴퓨터와 달리 데이터 처리와 저장을 동시에 수행하여 훨씬 더 적은 에너지로 복잡한 AI 연산을 수행할 수 있습니다. 아직 상용화 초기 단계입니다.

- 액체 냉각 (Liquid Cooling): 열이 많이 발생하는 컴퓨터 부품이나 서버를 공기 대신 물이나 특수 액체(냉각유)로 직접 식히는 방식입니다. 공기보다 열을 훨씬 잘 전달하기 때문에 고성능 서버의 발열을 효과적으로 잡고, 데이터센터의 냉방 에너지 소비를 크게 줄일 수 있습니다.

- HVAC (Heating, Ventilation, and Air Conditioning): 건물 내부의 난방, 환기 및 공기 조화(에어컨)를 모두 아우르는 시스템을 통칭하는 말입니다. 데이터센터에서 서버의 과열을 막고 적절한 온습도를 유지하는 데 필수적인 설비이며, 많은 전력을 소비합니다.

- 양자화 (Quantization): AI 모델의 계산에 사용되는 숫자들의 정밀도를 낮추는 기술입니다. 예를 들어, 아주 정교한 소수점 대신 간단한 정수로 계산하게 하여 모델의 크기를 줄이고 연산 속도 및 에너지 효율을 높입니다. 성능 손실을 최소화하면서 효율을 높이는 것이 목표입니다.

- 가지치기 (Pruning): AI 모델에서 중요하지 않거나 성능에 큰 영향을 주지 않는 부분을 잘라내어(가지치기) 모델의 크기를 줄이고 계산량을 줄이는 기술입니다. 불필요한 부분을 제거함으로써 모델을 더 가볍고 빠르게 만들 수 있습니다.

- 지식 증류 (Knowledge Distillation): 크고 성능이 좋은 '선생님' AI 모델이 학습한 지식이나 경험을, 더 작고 효율적인 '학생' AI 모델에게 가르쳐 주는 기술입니다. 이렇게 하면 학생 모델이 선생님 모델과 비슷한 성능을 내면서도 훨씬 적은 자원으로 작동할 수 있게 됩니다.

- 스마트 그리드 (Smart Grid): 정보통신기술(ICT)을 활용하여 전력망을 똑똑하게 만드는 시스템입니다. 전기가 생산되고, 전달되고, 사용되는 모든 과정을 실시간으로 확인하고 조절하여 에너지 낭비를 줄이고 전력망을 안정적으로 운영할 수 있도록 돕습니다.

- 제본스 역설 (Jevons Paradox): 기술이 발전해서 에너지를 더 효율적으로 쓰게 되면, 사람들이 그 에너지를 더 많이 쓰게 되어 결국 전체 에너지 사용량이 늘어나는 현상을 말합니다. 예를 들어, 연비 좋은 차가 나오면 사람들이 차를 더 많이 타게 되어 기름 소비가 줄지 않는 것과 비슷합니다. AI도 에너지 효율이 좋아져도 더 많은 곳에 활용되면서 전체 전력 소비가 늘 수 있다는 의미입니다.

- 이중 액체 냉각 (Dual Liquid Cooling): 단일 액체 냉각 방식보다 진보된 형태로, 서로 다른 특성의 냉각수 또는 액체를 사용하여 서버 내부의 특정 발열 부위(예: CPU, GPU)와 랙 전체를 각각 효율적으로 냉각하는 기술입니다.

- 재생에너지 간헐성 (Renewable Energy Intermittency): 태양광이나 풍력 발전과 같이 자연 조건에 따라 발전량이 불규칙하게 변하는 재생에너지의 특성을 말합니다. 이는 안정적인 전력 공급을 어렵게 만드는 요인 중 하나입니다.

- 에너지 저장 시스템 (ESS, Energy Storage System): 발전된 전력을 저장했다가 필요할 때 공급하여 전력 수급의 안정성을 높이는 시스템입니다. 재생에너지의 간헐성 문제를 보완하는 데 중요한 역할을 합니다.

- 가상 발전소 (VPP, Virtual Power Plant): 분산된 소규모 발전 자원(태양광, 풍력, ESS 등)들을 ICT 기술로 통합하고 제어하여 하나의 발전소처럼 운영하는 시스템입니다. 전력 시장에서 효율적인 에너지 거래와 전력망 안정화에 기여합니다.

- AI Act (EU AI Act): 유럽연합(EU)에서 제정 중인 인공지능 관련 법안으로, AI 시스템의 위험도에 따라 차등적인 규제를 적용하고, 인권, 안전, 투명성, 환경적 지속가능성 등을 강조하는 세계 최초의 포괄적인 AI 규제 프레임워크입니다.

'💡 스마트 라이프 가이드 > AI 시대의 그림자' 카테고리의 다른 글

| 💡[ 06편 ]🌐 AI 거버넌스와 책임: 규제, 투명성, 국제 협력의 과제 (0) | 2025.07.03 |

|---|---|

| 💡[ 05편 ]🛡️ AI 보안 위협: 사이버 공격과 자율 무기 시스템 (1) | 2025.07.02 |

| 💡[ 04편 ]🤖 AI의 사회경제적 파장: 노동 시장과 불평등 심화 (2) | 2025.07.01 |

| 💡[ 03편 ]⚖️ AI의 윤리적 딜레마: 편향, 프라이버시, 감시 (0) | 2025.06.30 |

| 💡[ 02편 ]🌍 환경에 드리운 AI의 그림자: 탄소, 물, 그리고 자원 고갈 (1) | 2025.06.29 |