오픈소스 LLM이 단순히 학술적 도구에 머물던 시대는 끝났습니다.

이 보고서는 2026년 초를 기준으로 Llama 5 및 이후의 오픈소스 모델들이 달성한 성능 지표를 분석합니다.

우리는 이제 단순한 성능 지표 논쟁에서 벗어나, 기업 도입의 핵심 동력인 총소유비용(TCO) 절감과 완전한 데이터 주권(Data Sovereignty) 확보에 집중하고자 합니다.

본 가이드는 즉각적인 편의성보다 통제권과 장기적인 비용 효율성을 우선시하는 아키텍트들을 위한 실전 지침서입니다.

1. 패러다임의 변화: 왜 데이터 주권이 새로운 기준인가

지난 수년간 폐쇄형(Proprietary) 모델은 핵심 벤치마크(MMLU, HumanEval)에서 압도적인 우위를 점해왔습니다.

그러나 Llama 5의 성능 수렴은 이러한 장벽을 사실상 제거했습니다.

현재 성능 격차는 5% 이내로 좁혀졌으며, 이제 폐쇄형과 오픈소스 모델 사이의 선택은 역량의 문제가 아닌 경제성과 보안의 결정 문제가 되었습니다.

이러한 수렴은 경쟁의 전장을 데이터 주권과 비용 통제력으로 완전히 옮겨 놓았습니다.

성능 수렴: Llama 5 벤치마크 (70B)

| 측정 지표 | Llama 5 (70B) | 최신 폐쇄형 모델(SOTA) | 핵심 시사점 |

|---|---|---|---|

| MMLU (추론) | 90.3% | 94.8% | 기능적 동등성 확보 |

| HumanEval (코딩) | 85.5% | 89.0% | 엔터프라이즈 코파일럿 수행 가능 |

2. 기술적 분석: MoE와 선택적 전문가 튜닝(Selective Expert Tuning)

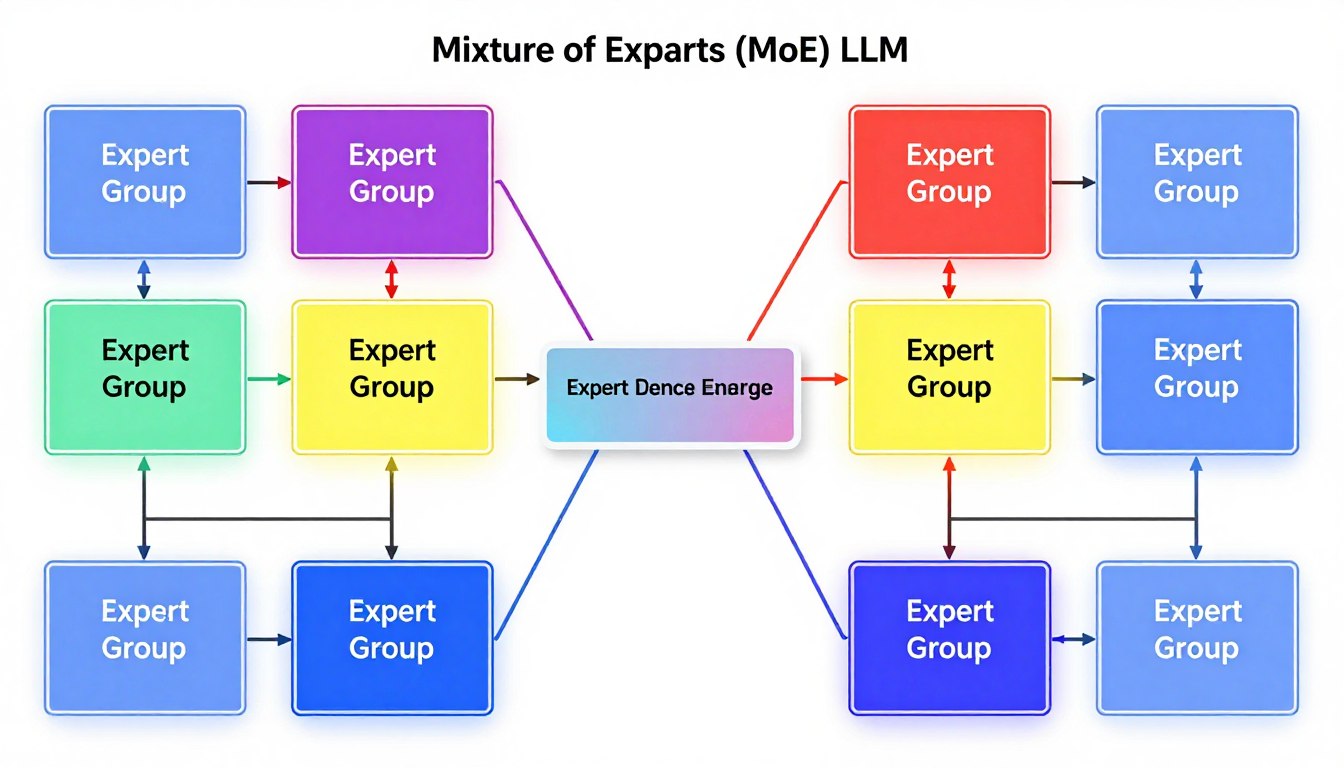

Llama 5의 아키텍처적 효율성은 고도화된 전문가 혼합(Mixture-of-Experts, MoE) 구조에 기반합니다.

모든 파라미터를 사용하는 밀집 모델과 달리, MoE는 추론 시 전문화된 신경망(전문가)의 하위 집합만을 활성화합니다.

이는 연산 부하를 줄여 처리량을 20% 이상 향상시킵니다. 핵심은 단순히 MoE를 쓰는 것이 아니라, 그 위에 구축된 선택적 전문가 튜닝(Selective Expert Tuning) 기법을 활용하는 것입니다.

고급 기업용 파인튜닝: Selective Expert Tuning

기업들은 이제 단순한 LoRA를 넘어, MoE 아키텍처 내 특정 전문가 그룹을 사내 전문 데이터(의료, 금융 등)에 매핑하는 기법을 사용합니다.

이 방식은 최소한의 데이터로 최대의 도메인 정확도를 달성하며 학습 비용을 획기적으로 낮춥니다.

3. 실전 사례: 규제 준수와 처리량 극대화를 위한 Llama 5 활용

Llama 5의 가치는 기업 방화벽 내부 배포(데이터 주권)에 있습니다. 외부 API 사용이 제한된 환경에서의 PoC는 RAG와 선택적 전문가 튜닝의 결합에 집중됩니다.

시나리오 A: 대규모 금융 규제 준수 분석

목표: 내부 법률 DB를 활용해 위험 조항 식별 자동화 및 GDPR/HIPAA 준수.

| 항목 | 상세 내용 |

|---|---|

| 사용 모델 | 법률 용어에 특화 튜닝된 Llama 5 (70B) |

| RAG 프롬프트(개념) | "문서 [ID: 7421] 내 불가항력 조항 식별 및 사내 정책 대조" |

| 성과 지표 | MoE 효율을 통한 기존 모델 대비 처리량 20% 향상 |

시나리오 B: 사내 보안 코드 코파일럿 구축

목표: 지적 재산권 유출 없이 사내 코드 베이스를 활용하는 어시스턴트 구축.

| 항목 | 상세 내용 |

|---|---|

| 튜닝 방법 | 사내 보안 표준에 맞춘 Selective Expert Tuning |

| 보안 보장 | 모든 데이터가 사내 인프라 내에 100% 잔류 |

4. 현실적인 제약: 오픈소스 도입의 숨겨진 비용

대량 사용자 기준 40%의 TCO 절감이 가능하지만, 이는 높은 CapEx와 전문 운영 인력을 필요로 합니다. 오픈소스가 '무료'라는 생각은 위험한 오해입니다.

TCO 혁명: 고정비 vs 변동비

| 비용 구성 | 폐쇄형 API | Llama 5 자체 호스팅 |

|---|---|---|

| 구조 | OpEx (변동비) | CapEx (고정비/상환) |

| TCO (대량 처리) | 높음 (선형 증가) | 최대 40% 비용 절감 |

인프라 및 MLOps 부담

| 항목 | 요구사항 및 비용 예상 |

|---|---|

| GPU | NVIDIA H100/B200급 클러스터 (수백만 달러 규모) |

| MLOps | 전담 엔지니어 팀(DevOps, 보안) 구축 필수 |

5. 구현 가이드: RAG 파이프라인 전략

Llama 5를 내부 지식 베이스의 핵심 엔진으로 배치하여 외부 리스크를 원천 차단하는 전략입니다.

단계별 배포 전략

- 단계 1: 경량 파인튜닝 (PEFT) - LoRA 등을 활용해 기업 고유 톤과 형식으로 정렬.

- 단계 2: 지식 통합 (RAG) - 튜닝된 모델을 사내 벡터 데이터베이스와 연결.

- 단계 3: 관리형 서비스 활용 - 초기 비용이 부담될 경우 Azure AI Foundry 같은 관리형 서비스로 시작.

6. 요약: 워크플로우 아키텍트를 위한 핵심 시사점

- 성능 동등성: Llama 5는 폐쇄형 모델과의 격차를 없앴으며, 이제 경제성과 규제 대응이 핵심입니다.

- 경제적 필연성: 대량 사용 시 고정비 구조 전환을 통해 최대 40%의 TCO를 절감할 수 있습니다.

- 보안 및 주권: 민감 데이터를 다루는 산업군에서 100% 데이터 주권을 확보하는 최적의 대안입니다.

'💡 스마트 라이프 가이드' 카테고리의 다른 글

| 2026년 AI 노트북 분석: NPU 성능부터 코파일럿+ 활용법까지, 현명한 선택을 위한 전문가 가이드 (0) | 2026.01.26 |

|---|---|

| 2026 AI 시장 대전환: 산업 특화 AI와 마이크로 SaaS, 당신의 비즈니스를 재정의할 실전 전략 (0) | 2026.01.23 |

| 2026년 무선 이어폰: 숫자와 데이터로 검증된 최적의 선택 가이드 (0) | 2026.01.21 |

| 2026년, GaN 고속 충전기는 선택 아닌 필수: 기술 분석과 실제 가치 (0) | 2026.01.21 |

| AI 신약 개발 워크플로우 벤치마크: IND 기간 71% 단축과 2026년 규제(GaiP) 대응 전략 (0) | 2026.01.16 |

| 2026년 자율 에이전트 도입 가이드: GPT-Agent OS vs. Gemini, M-TSR과 CPT 기반 ROI 분석 (0) | 2026.01.16 |

| AI 비디오 '장편 일관성' 확보: 3배 비용을 감수하고 90초 영상을 만드는 워크플로우 분석 (0) | 2026.01.16 |

| PCIe 6.0, Wi-Fi 7, 정말 '체감'될까? 2026년 최신 표준 업그레이드, 돈값 하는지 냉철 분석 (0) | 2026.01.14 |